HEERLEN, 13 februari 2026 – Onderzoekers zetten kunstmatige intelligentie (AI) in om de detectie van zwaartekrachtsgolven te verbeteren, zelfs wanneer signalen verborgen zijn onder onvoorspelbare ruis en verstoringen in meetapparatuur. In zijn promotieonderzoek laat onderzoeker Tom Dooney zien hoe deep learning-technieken ruis uit zwaartekrachtsgolfdata kunnen verwijderen, waardoor echte astrofysische signalen sneller en nauwkeuriger worden herkend.

Het onderzoek, getiteld Deep Learning for Modelling and Separating Gravitational Wave Signals, Glitches, and Noise, slaat een brug tussen data science, natuurkunde en AI. De resultaten zijn relevant voor de verdere ontwikkeling van de zwaartekrachtsgolfastronomie en voor grootschalige projecten zoals de Einstein Telescope, die mogelijk in Limburg wordt gevestigd.

Rimpelingen in de ruimtetijd

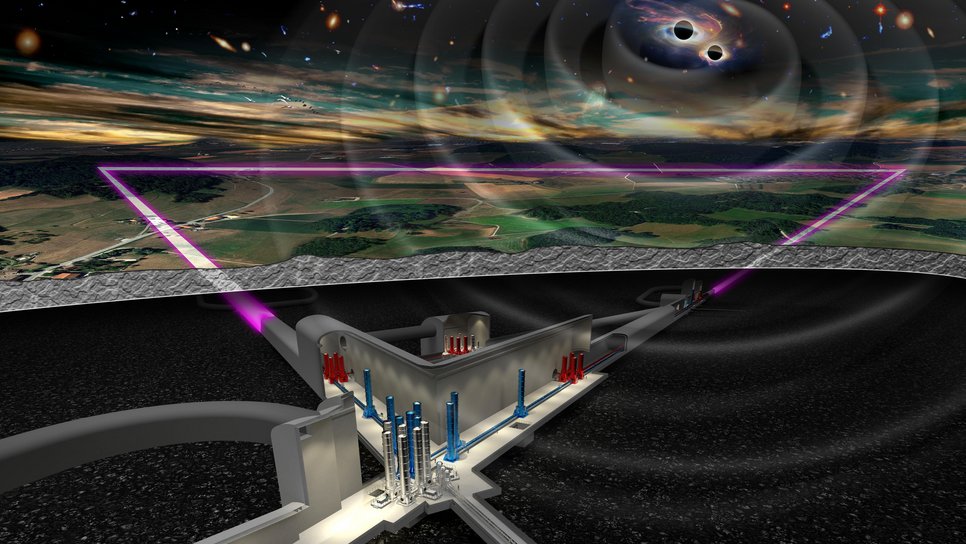

Zwaartekrachtsgolven ontstaan bij extreme kosmische gebeurtenissen, zoals botsingen tussen zwarte gaten en neutronensterren. Deze gebeurtenissen veroorzaken kleine rimpelingen in de ruimtetijd, die worden gemeten met uiterst gevoelige detectoren. Naarmate de meetapparatuur gevoeliger wordt, neemt ook de hoeveelheid verstoringen toe. Deze korte en onvoorspelbare ruissignalen, zogenoemde glitches, kunnen echte zwaartekrachtsgolven nabootsen of verhullen.

Leren wat ‘normale’ ruis is

Dooney ontwikkelde AI-methoden die leren hoe de normale achtergrondruis van detectoren eruitziet. Alles wat daarvan afwijkt, kan automatisch worden herkend en gescheiden van die achtergrond. Hierdoor kunnen onderzoekers zowel bekende astrofysische gebeurtenissen, zoals fusies van binaire zwarte gaten, als onbekende of moeilijk te modelleren signalen beter isoleren en analyseren.

Daarnaast toont het onderzoek aan dat generatieve AI kan worden gebruikt om realistische zwaartekrachtsgolfsignalen en glitches te simuleren. Deze simulaties maken het mogelijk om detectoren en analysemethoden uitgebreid te testen en verder te verbeteren.

Voorbereiding op de Einstein Telescope

Het proefschrift richt zich op de ontwikkeling van snellere en flexibelere hulpmiddelen die echte signalen betrouwbaar van ruis kunnen scheiden, zelfs wanneer die signalen onbekend zijn of overlappen met glitches. Volgens Dooney maken deep learning-methoden schonere en robuustere zwaartekrachtsgolfmetingen mogelijk.

Dat is van belang met het oog op detectoren van de volgende generatie, zoals de Einstein Telescope. Dit Europese observatorium zou vanuit Limburg dagelijks honderden kosmische gebeurtenissen kunnen detecteren en zal een ongekende hoeveelheid data opleveren.

Een belangrijk voordeel van de nieuwe aanpak is dat glitches kunnen worden verwijderd zonder dat het algoritme vooraf hoeft te weten hoe deze verstoringen eruitzien. Het systeem leert uitsluitend het normale gedrag van detectorruis. Door deze voorspelde ruis van de meetdata af te trekken, blijven zowel verstoringen als echte zwaartekrachtsgolfsignalen zichtbaar, waardoor ook signalen van voorheen onbekende kosmische bronnen kunnen worden ontdekt.

Over Tom Dooney

Tom Dooney (Dublin, 1995) startte zijn promotieonderzoek in januari 2022. Dit jaar is hij begonnen aan een postdoctorale onderzoekspositie bij Nikhef. Hij behaalde in 2018 een bachelor Theoretical Physics aan University College Dublin en in 2021 een master Data Science aan Maastricht University.

Op donderdag 26 februari 2026 om 16.00 uur verdedigt hij zijn proefschrift aan de faculteit Bètawetenschappen van de Open Universiteit in Heerlen. De verdediging is ook online te volgen via ou.nl/live.

Het proefschrift werd begeleid door dr. Stefano Bromuri, prof. dr. Chris van den Broeck, dr. Daniel Tan en dr. Lyana Curier.